李静涛:基于监督微调构建中医大语言模型的实践探索

随着大语言模型(LargeLanguageModels,LLMs)在自然语言处理领域的广泛应用,其在医疗行业中的潜力也日益显现。然而,当前主流大模型在特定领域如中医学中的表现仍存在专业性不足的问题。本文基于笔者在AI产品的实际开发经验,探讨了如何利用开源中医药数据集TCMChat-dataset-600k和Qwen2.5-32B-Instruct模型,通过监督微调(SupervisedFine-Tuning,SFT)方法构建一个面向中医领域的定制化大语言模型——SmartSage-ZYLLM-32B,并将其作为“智医灵枢”项目的中医智能模块进行集成应用。

一 项目起源与背景介绍

“智医灵枢”是一个面向医疗行业的多模态AI智能助手系统,具备行政办公对话支持、临床病历辅助生成等功能。然而,长期以来,该系统缺乏针对中医领域的深度支持模块,难以满足中西医结合服务的实际需求。

中医理论体系复杂、术语体系独特,对AI系统的语义理解和推理能力提出了更高的要求。为此,笔者尝试引入高质量的中医语料并结合大语言模型技术,构建一个具备中医知识背景的专业模型,以丰富“智医灵枢”的功能边界。

二 数据来源与研究基础

本研究采用的数据集为浙江大学范骁辉教授团队开源的TCMChat-dataset-600k。该数据集包含超过60万条中医药相关的问答样本,涵盖中医基础理论、证候辨识、中药配伍、针灸推拿等多个维度,其中特别附带了一个4.8万条记录的中医诊疗知识库,具有较高的训练价值。

范骁辉教授为浙江大学求是特聘教授、国家重大人才工程特聘教授,现任浙江大学长三角智慧绿洲创新中心主任。其团队在中医药数字化、人工智能辅助诊断等方面已有深入研究成果,为本研究提供了坚实的数据支撑。

三 技术方案与实现路径

1.模型选择与微调策略

考虑到部署效率与成本控制,本研究选用Qwen2.5-32B-Instruct作为基准模型,通过监督微调(SFT)方式进行领域适应训练。相较于更大规模的模型(如Qwen3-235B-A22B),该模型在参数量与资源消耗之间取得了较好的平衡。

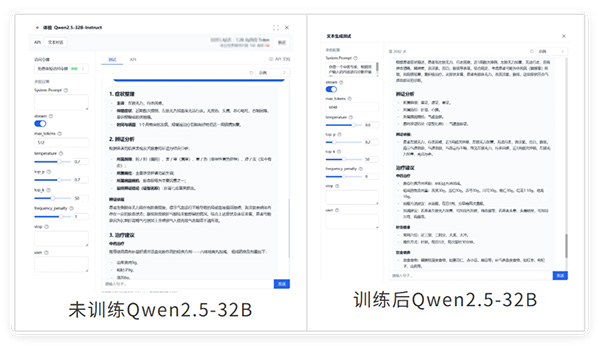

尽管未经训练的Qwen2.5-32B在中医任务中表现一般,但经过SFT微调后,其在术语使用规范性、推理逻辑连贯性以及回答准确性方面均有显著提升,具备较强的中医问答能力。

2.监督微调(SFT)技术介绍

监督微调是一种在预训练语言模型基础上,使用标注好的下游任务数据对其进行进一步训练的方法。其核心思想是将通用语言模型适配到特定任务或领域中,从而提升模型在目标场景下的性能。具体而言,SFT过程包括以下几个步骤:

数据准备:整理符合任务格式的问答对;

模型加载:加载预训练模型及其权重;

训练配置:设定学习率、优化器、批次大小等超参数;

微调训练:使用标注数据对模型进行有监督训练;

评估测试:在验证集上测试模型效果;

部署上线:将训练完成的模型封装并部署至应用场景。

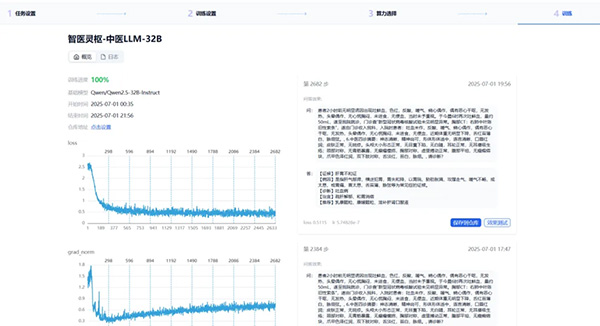

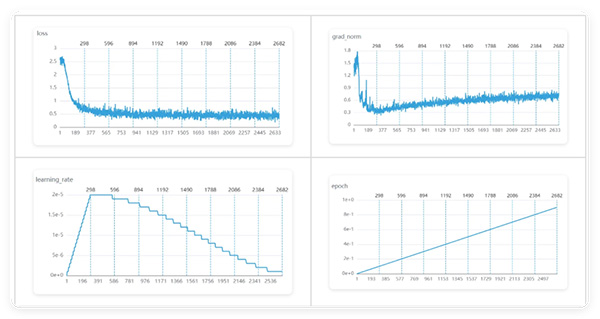

本次微调共进行了约2682个训练步数,训练时长约21小时,最终得到一个能够根据预设逻辑进行中医问答的定制化模型。

3.算力环境与训练配置

本研究的全部训练工作在第三方训练平台上完成,训练环境配置为12核CPU、32GB内存以及单卡64GB显存,基准模型选用Qwen2.5-32B-Instruct,在该硬件与模型组合下完成了监督微调训练流程。

四 实测效果与性能分析

在实际测试过程中,笔者将微调后的模型与Qwen3-235B-A22B模型进行对比。结果显示,尽管后者在理解能力和输出质量上更为出色,但其运行成本较高,显存占用大、推理延迟高,难以满足实时交互需求。

相比之下,微调后的Qwen2.5-32B 在保持良好响应速度的基础上,展现出较高的专业水准。在术语使用方面,模型能够准确运用“肝郁脾虚”“痰湿中阻”等中医专业术语,提升了内容的权威性与准确性;在回答逻辑上,具备一定的辨证思维能力,能够根据输入症状进行合理的推理与分析;此外,在实际交互过程中,模型响应迅速,具备良好的实时对话体验,非常适合嵌入“智医灵枢”系统中,作为轻量级模块进行部署与应用。

这表明,在医疗AI开发进入“深水区”之后,不一定要从头做起进行预训练,但微调工作却是必不可少的一环。

五 实践总结与行业思考

1.微调是降本增效的关键路径

在医疗行业中,模型的部署往往受限于硬件资源与响应速度要求。通过精准的监督微调,可以在保证模型专业性的前提下,有效降低计算资源消耗,提高部署可行性。

2.提示词工程仍是应用开发的核心

即便完成了微调,提示词(PromptEngineering)的设计依然是决定输出质量的关键因素。笔者发现,同一模型在不同提示词引导下,输出内容的专业度和逻辑性差异显著。因此,在AI应用开发中,必须充分理解并利用模型的注意力机制,设计出更符合业务需求的提示结构。

3.数据质量比模型大小更重要

在整个项目过程中,笔者对数据集的重要性有了更深层次的理解。虽然TCMChat-dataset-600k是一个优质开源数据集,但在实际训练中仍存在部分噪声和不一致之处。后来,笔者尝试用Qwen3-235B-A22B对数据进行初步分析与规范化处理,发现这种方式能有效提升后续微调的效果。

因此,对于医疗机构或研究单位来说,在进入模型微调阶段之前,应优先关注数据集的清洗与优化。借助大模型的强大语义理解能力,对已有数据进行标准化、归一化处理后再用于微调,可能是打造专业级医疗AI的正确路径。

六 未来展望与开源说明

本次微调训练的成功为“智医灵枢”项目的功能拓展带来了新的可能性。下一步,计划将训练完成的中医模型作为独立模块集成到系统主框架中,逐步实现中医问诊辅助、药膳智能推荐以及经典文献解读等功能。同时,也将在更多垂直场景中探索模型的应用潜力,例如体质辨识与节气养生等方向。在此基础上,团队还将持续优化模型性能与提示词体系,进一步提升系统的智能化水平与用户交互体验。

1.项目开源

本研究训练所得模型SmartSage-ZYLLM-32B已正式开源,旨在为中医智能化发展提供一个可落地、可扩展、可持续优化的技术基础。该模型基于Qwen2.5-32B-Instruct架构,并在高质量中医药问答数据集TCMChat-dataset-600k 上进行了监督微调(SFT),具备较强的中医术语理解能力与辨证推理逻辑。

我们诚挚欢迎广大开发者、研究人员及中医爱好者下载使用本模型,并基于其进行二次开发与功能拓展。无论是构建中医智能问答系统、辅助诊疗工具,还是开展中医知识图谱、个性化养生推荐等相关研究,SmartSage-ZYLLM-32B 都可作为良好的起点。

2.项目致谢

感谢范骁辉教授团队开源的TCMChat-dataset-600k数据集,为本次项目提供了坚实基础。

点击此处可查看项目地址

(作者单位:云南省曲靖市富源县人民医院医学装备科)

首 页

首 页