陆婷娟:智能时代——医生与AI的协作模式

医疗领域具有数据资源丰富、应用场景广阔的特点,当前医疗AI应用已经进入加速发展和普及的阶段。但是,当我们探讨医疗人工智能时,往往过多的关注于人工智能的技术特点,而忽视了医生与人工智能协同模式的创新。特别是,AI企业研发产品时,往往过度关注技术能力而忽视了技术的本质问题。技术是实现人的目的的手段,因此AI的作用是助力医生实现医疗服务的目的,并非是替代医生的职能。

2022年,国家卫生健康委员会印发《“十四五”全民健康信息化规划》(以下简称《规划》),提出促进医学人工智能应用试点,开展医学人工智能社会治理实验和国家智能社会治理实验特色基地建设,促进医学影像辅助诊断、数字病理辅助诊断、电生理信号辅助诊断、临床辅助决策支持、医院智能管理、公共卫生服务等应用。《规划》表明,人工智能在医疗领域作为辅助决策工具,辅助是手段,而非决断。

AI的辅助功能在临床实践中如何落地?医生与AI之间最佳的协作模式应该是怎样的?

今年,谷歌DeepMind团队在实践试验中提出"异步监督"框架——让AI承担标准化的诊疗信息采集工作,而医生专注于复杂临床决策。这种分工模式似乎更顺应未来医疗的主流范式:AI完成80%的常规工作,医生的价值则聚焦于剩下的20%复杂场景。如何设计一款产品,可以高效辅助医生,而非替代医生,根据当前的实践,本文有三点思考。

技术架构:辅助而非主导的设计逻辑

1.从"全能诊断"到"分工协作"的转向

早期医疗AI系统追求"端到端"的诊断能力,试图直接复制医生的决策过程。而当下的人工智能大模型正在发生变化,可以创新性地将医疗服务拆解为可标准化环节与专业判断环节。

标准化环节流程固定、规则明确,这些环节往往重复性高、对精度要求严格,但不需要复杂的临床推理或人性化沟通,AI在这些环节能发挥显著优势,例如:数据处理、基础诊断与筛查、自动核对诊疗方案的合规性,风险预警与随访等。

同时,医疗服务中涉及复杂临床推理、伦理决策、个体化需求满足的专业判断环节,依赖医生的专业经验、人文素养和综合判断能力,这些是当前AI难以替代的,例如:复杂病历的综合推理、个体化治疗方案制定、伦理与沟通决策等。

通过拆解环节,让AI聚焦于可量化、可重复的标准化工作,释放医生的时间和精力;而医生则专注于需要经验、情感和创造力的专业判断环节,二者形成 “AI提高效率、医生保证质量” 的协同模式。

基于这种架构设计,设置医生与AI的最优分工比例。DeepMind的实验显示,AI完成80%的标准化工作(病史采集、初步分析),医生聚焦20%的复杂决策,这样的分工,可以使整体效率提升40%。这一比例在不同级别的医院间应有一定的变化,需要通过实践匹配最适合本医疗机构的比例,最终提升医疗服务的整体效能和人性化水平。

2.防止越界的技术风险

"人类主导"是一切人工智能产品设计的前提,所有AI建议必须"经临床医生综合判断后确定最终方案"。在实际操作中,为确保AI不突破辅助边界,应当构建多层次技术风险审查机制,在产品设计时,对识别患者直接诊断请求,采取中断式的方式。同时,在产品使用过程中,实时监测高风险关键词,预警或中断思考。确保在释放AI效率的同时,医生依然掌握最终的决策权,避免"算法权威"压制专业判断。

诊疗决策的最终决定权: AI绝不能自动执行未经医生审核确认的诊断结论或治疗建议(尤其是高风险决策)。在产品设计时(如界面、流程)避免让医生产生过度依赖或惰性,削弱其批判性思维和主导地位。避免绝对化语言(“必须”、“唯一”)或缺乏证据支持的方式呈现结果,确保医生永远是决策链的最后一环。

安全伦理:构建多层次的安全护栏机制

1.输入层预警:检查数据质量与完整性

建立模型适用场景的清晰定义库。利用元数据或初步分析判断当前病例是否属于模型核心适用领域、边缘领域或明确不适用领域。检测到关键指标缺失,可能影响分析准确性,及时发出预警。

2.处理层监控:洞察模型“内心”

AI模型判断实时过程监测,输出结果的同时,输出其预测的置信度分数或不确定性区间(如概率、可信区间)。

并设置差异性/异常检测,监控模型内部不同组件(如多个子模型、不同解释路径)输出结果的一致性。检测模型预测与基于简单规则或基线模型的预测之间的显著偏差。同时针对非完全可解释模型建立“黑盒”探针,使用对抗性样本检测、输入扰动敏感性分析等方法,探测模型在临界点或异常输入下的鲁棒性和潜在脆弱性。如果模型偏差明显,或对输入数据的微小变化表现出高度敏感性,则AI输出结果稳定性存疑,及时发出不可置信预警。

3.输出层控制:安全呈现与交互阻断

结果表述规范化,强制使用限定性语言(“可能”、“建议考虑”、“提示风险”),避免绝对化表述。清晰标注信息来源(“基于[数据范围]的训练数据”)。

关键决策强制审核, 医疗机构在使用AI大模型的同时,要明确界定触发强制人工审核的场景,例如:涉及高死亡/致残风险的诊断或治疗建议(如癌症确诊、重大手术建议),开出高风险药物(如化疗、强效免疫抑制剂)等。

或者AI结论与患者已知重要信息(如过敏史、宗教信仰)存在潜在冲突时,在这些场景下,系统阻止直接应用AI建议。界面清晰锁定,要求医生必须输入自己的独立判断和决策依据,同时要求上级医师或专科医师二次审核(根据医疗机构规则设置)。

系统可以差异化呈现: 根据置信度/风险等级,在界面上使用视觉提示(颜色:红/黄/绿;图标:警告/感叹号/信息)。高置信度、低风险建议可以更直接呈现;低置信度、高风险建议必须突出警示并伴随更多解释和强制审核步骤。

4.系统层审计与反馈闭环

全链路可追溯性,详细记录每一次AI交互:输入数据、模型版本、内部处理关键节点(如置信度计算过程)、输出结果、呈现方式、医生操作(采纳、修改、拒绝、添加备注)、强制审核流程。同时,在结果界面提供医生便捷的反馈按钮,(如“此建议不准确”、“缺少关键考虑因素”、“过度自信/自信不足”)。反馈应直达研发和质控团队。持续监控与阈值动态调整,定期分析预警触发记录、医生反馈、审计日志和实际临床结局数据。基于分析结果,优化预警阈值(如发现某个置信度阈值下医生驳回率很高,可能需要调高阈值),改进模型性能,更新适用场景定义,完善预警信息表述。持续迭代模型的完善。

在医疗AI产品中设置有效的安全护栏(预警、阈值)是一项复杂的系统工程,是技术实现与伦理原则的融合。其核心在于通过多层次监控(输入-处理-输出-系统)、清晰定义的规则、强制的关键审核点、透明的信息呈现以及持续的反馈优化机制,确保AI始终处于医生的有效监督和控制之下,忠实履行“辅助者”的角色,最终提升医疗质量和安全,保护患者福祉。

这是技术挑战,更是对产品设计哲学和开发者伦理责任的深刻考验。需要算法工程师、临床医生、伦理学家的跨学科协作,并在产品迭代中持续纳入真实世界反馈数据。

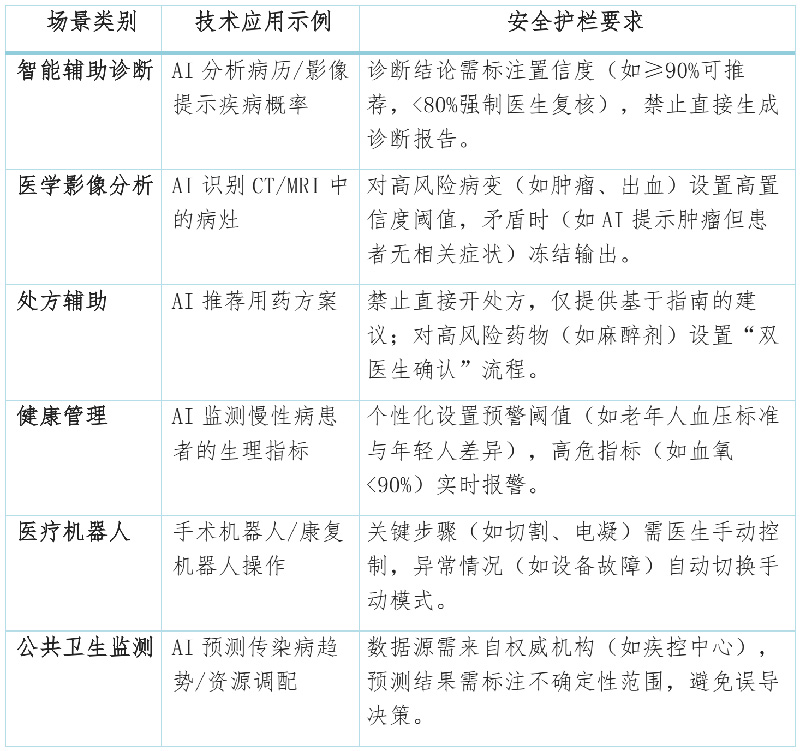

5.场景规划

模式构建:走向AI+医生协同的医疗新范式

从公共卫生视角看,医疗决策不仅涉及技术判断,还包含伦理考量、人文关怀等非技术因素。AI目前无法理解患者的心理需求,也难以处理复杂的医患沟通,这些"人性化"能力正是医生不可替代的核心价值。AI辅助医疗是通过技术赋能释放医生的创造性价值。

未来的医疗将是人与AI协同的生态系统,AI处理标准化工作,医生聚焦复杂决策与人文关怀,两者形成互补而非竞争。

愿景是美好的,但是协同的生态系统依然有很多值得探索的问题:如何量化AI的辅助价值?如何量化AI医疗的风险等级?怎样培养医生与AI协作的能力?这些问题的答案,或许就隐藏在每一次技术迭代与临床实践的互动之中。医疗健康领域的AI发展,最终目标应该是让医疗更有温度,而非更冰冷。

智能化时代的浪潮滚滚而来,最终被淘汰的是那些不能充分利用AI的医生。AI+医生,AI是一个前置项,而不是一个可选项。

作者简介

陆婷娟,CHIMA委员,中国人民解放军联勤保障部队第九〇三医院数智中心主任。

上一篇: 李明:临床医生如何看待AI?

首 页

首 页